这篇文章主要介绍了Tensorflow训练模型默认占满所有GPU的解决方案,具有很好的参考价值,希望对大家有所帮助。如有错误或未考虑完全的地方,望不吝赐教

Tensorflow训练模型默认占满所有GPU问题

在使用gpu服务器训练tensorflow模型时,总是占满显存!

TensorFlow默认的是占用所有GPU

因此我们需要手动设置使用的GPU编号以及单个GPU显存占用比例

1.第一步需要在代码中开头加入

import os

os.environ["CUDA_DEVICE_ORDER"] = "PCI_BUS_ID" # 按照PCI_BUS_ID顺序从0开始排列GPU设备

os.environ["CUDA_VISIBLE_DEVICES"]=‘0' # 使用0号gpu(想使用其他编号GPU,对应修改引号中的内容即可)

os.environ["CUDA_VISIBLE_DEVICES"]=‘0,1' # 使用0号GPU和1号GPU2.第二步需要将代码中的sess = tf.Session()改为

gpu_options = tf.GPUOptions(per_process_gpu_memory_fraction=0.333) # 通过改变0.333可以改变占用显存比例

sess = tf.Session(config=tf.ConfigProto(gpu_options=gpu_options))per_process_gpu_memory_fraction=0.333代表的含义就是每个GPU进程中使用显存的上限为该GPU总量的1/3

3.如果想要在程序运行过程中连续查看GPU信息

可以在终端使用该 指令(执行指令:watch -n 3 -d nvidia-smi # 每隔三秒输出一次)(前提是设备中有合适的NVIDIA驱动)

解决tensorflow2.2把GPU显存占满

安装了tensorflow-gpu后,运行程序默认是把GPU的内存全部占满的,有时我们不想全部占满,可以这样操作。

解决代码

import tensorflow as tf

import os

os.environ['CUDA_VISIBLE_DEVICES']="0" # 指定哪块GPU训练

config=tf.compat.v1.ConfigProto()

# 设置最大占有GPU不超过显存的80%(可选)

# config.gpu_options.per_process_gpu_memory_fraction=0.8

config.gpu_options.allow_growth = True # 设置动态分配GPU内存

sess=tf.compat.v1.Session(config=config)如图:

总结

以上为个人经验,希望能给大家一个参考,也希望大家多多支持编程学习网。

本文标题为:Tensorflow训练模型默认占满所有GPU的解决方案

基础教程推荐

- redis 数据库 2023-09-13

- redis乐观锁与悲观锁的实战 2023-07-13

- oracle19c卸载教程的超详细教程 2023-07-23

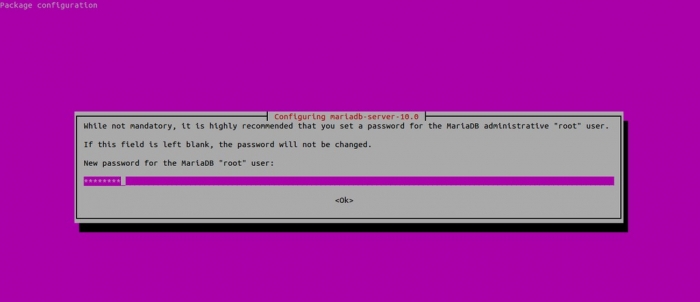

- Mariadb数据库主从复制同步配置过程实例 2023-07-25

- Python安装第三方库的方法(pip/conda、easy_install、setup.py) 2023-07-28

- Python常见库matplotlib学习笔记之画图中各个模块的含义及修改方法 2023-07-27

- Java程序员从笨鸟到菜鸟(五十三) 分布式之 Redis 2023-09-11

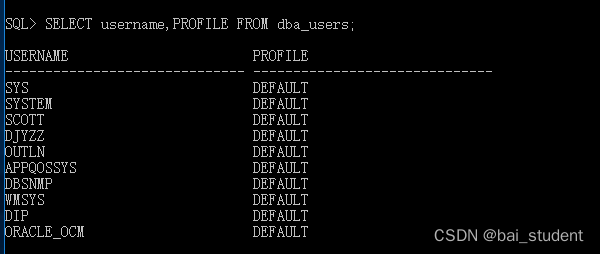

- oracle数据库排序后如何获取第一条数据 2023-07-24

- SQL Server如何设置用户只能访问特定数据库和访问特定表或视图 2023-07-29

- Windows10系统中Oracle完全卸载正确步骤 2023-07-24